Des chatbots ressemblent de plus en plus aux humains, …avec tous leurs défauts

Par Mathilde Caubel, MediaLab de l’Information à France Télévisions

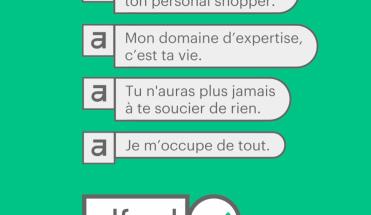

Les chatbots sont au centre des tendances technologiques depuis le milieu des années 2010. Mais ces compagnons algorithmiques sont loin d’avoir atteint le brillant avenir que certains leur promettaient. Si l’utilisation de chatbots n’est plus perçue comme révolutionnaire, les progrès de l’Intelligence Artificielle ont permis d’étendre et de diversifier leurs usages. Grâce au Deep Learning, un chatbot peut tenir un discours aussi pertinent et idiomatique qu’un être humain, à condition d’avoir préparé le sujet.

Mais qu’en est-il des thématiques complexes et des questions éthiques autour des données qui alimentent les algorithmes ? Le récent dérapage du chatbot coréen Lee LuDa a ouvert un débat sur les zones d’ombre des bots alimentés à l’IA, et a soutenu l’appel actuel pour un cadre éthique autour de leur utilisation.

Des IA conversationnelles de plus en plus humaines ?

Il est vrai qu’au travers de chatbots commerciaux, l’IA a permis d’automatiser beaucoup de tâches dans les relations clients. Conjointement, l’utilisation des chatbots pour le suivi de santé est un réel progrès pour les personnes vivant dans des déserts médicaux. Comme beaucoup de technologies de l’E-santé, les bots sont particulièrement sollicités en temps de pandémie mondiale.

Bien que le “Machine Learning” et le “Deep Learning” aient rendu la création et l’éducation de chatbots plus rapide et accessible, un problème d’automatisation persiste. Face à la complexité de certaines thématiques, où à la spontanéité des utilisateurs, les chatbots demandent un travail conséquent d’alimentation et de modération de la part de l’être humain.

Certains rêvent toujours d’une IA conversationnelle plus vraie que nature. En effet, le brevet du chatbot Microsoft approuvé fin 2020, semble relever de la science-fiction. L’objectif serait de pouvoir interagir avec une personne décédée grâce à un chatbot alimenté avec des données recueillies sur les réseaux sociaux et messageries. Cet ersatz pourrait aussi remplacer une personne bien vivante mais inaccessible, une célébrité par exemple. Ce projet relativement optimiste quant aux pouvoirs de l’IA a rappelé à beaucoup d’internautes un épisode de la série Black Mirror et beaucoup s’inquiètent du cadre juridique et éthique d’une telle innovation.

Imaginez un chatbot qui parle comme vous, qui a votre personnalité, car il a été créé à partir de toutes les données qu’on peut trouver sur vous en ligne (avant ou après votre mort).

Microsoft vient de déposer un brevet pour ça 🤖https://t.co/8MPqCcr8Re pic.twitter.com/nJl9KV8V5P— Leïla Marchand (@LeilaMarchand) January 25, 2021

Des zones d’ombre du côté de la modération et de l’éthique

Dès son lancement, l’IA conversationnelle coréenne Lee LuDa a rencontré un succès retentissant. Incarnant une jeune étudiante de 20 ans, ce chatbot compte bien devenir l’amie virtuelle des jeunes Coréens. Lancé début janvier par l’entreprise ScatterLab, ce chatbot Messenger est loin d’être le premier de ce type en Corée du Sud. Mais il a rapidement gagné une notoriété internationale à cause de ses nombreux dérapages, qui rappellent la mésaventure de Tay, le chatbot Microsoft sorti pour une très courte vie en 2016. Des utilisateurs ont partagé des conversations où le bot tenait des propos haineux sur des minorités, en plus de discours sexuellement explicites. Malgré une rectification de l’algorithme par le créateur et son optimisme quant à l’éducation du bot, le service a été interrompu moins d’un mois après son lancement.

Cette affaire a aussi éveillé des interrogations sur la légalité de la collecte des données grâce auxquelles le programme de Deep Learning de ScatterLab a été alimenté. En effet, il a été nourri de conversations de la messagerie KakaoTalk, une autre application de la start-up. Le pot-au-roses à été découvert lorsque le chatbot LuDa a énoncé des noms de proches ainsi que des numéros de compte en banques, échangé dans les conversations privées sur KakaoTalk. L’entreprise clame n’avoir utilisé ces conversations que dans le seul but de rendre le discours du robot plus naturel, et affirme avoir demandé l’autorisation aux utilisateurs. Mais les conditions de confidentialité ont été jugées trop obscures, et un recours collectif a été déposé contre Scatter Lab pour violation de l’Acte de Protection des Données Personnelles.

Dans le thread Twitter ci-dessous, un journaliste anglais basé à Séoul explique l’évolution de l’affaire Lee LuDa, des premiers dérapages jusqu’aux poursuites judiciaires qu’encourent ses créateurs.

So there’s this new Korean chatbot called Iruda (이루다) doing the rounds online at the moment, making headlines for being sexually harassed.

The bot is also homophobic and transphobic. People on forums wondering how its algorithm works… pic.twitter.com/mjTTkowc0c

— Raphael Rashid (@koryodynasty) January 9, 2021

Ce dérapage d’une intelligence artificielle est arrivé peu de temps après celui du modèle de traitement du langage naturel GTP-3 d’OpenAI, pourtant l’un des plus perfectionnés sur le marché. Pendant les phases de tests de ce modèle pour des bots médicaux, un des bots avait conseillé à un faux patient de mettre fin à ses jours. Cet accident éthique a provoqué de fortes inquiétudes au sein de la société OpenAI qui a décidé de limiter GTP-3 a une forme bêta privée.

Jack Clark, OpenAI Policy Director “ Nous mettrons fin à l’accès de l’API pour des cas d’utilisation manifestement dangereux, tels que le harcèlement, le spam, la radicalisation ou les fakes news.”

L’erreur reste humaine

Le scandale Lee LuDa a été d’autant plus impactant qu’il fait écho à des problèmes de sexisme et de discrimination auxquels fait face la société coréenne. Il a révélé des questionnements sur la transparence et l’éthique de l’utilisation des bots et de l’intelligence artificielle. Malgré les avancées en matière d’IA et de Deep Learning, ce type de dérapage soutient le besoin d’un cadre légal et d’une modération. La prévention des mauvaises utilisations de l’IA et un appel pour sa régulation ont d’ailleurs été au centre des discussions du Forum de Davos 2021.